Beter publiek prestatiemanagement

2 januari 2014 om 12:47 0 reacties

Als aandacht en inzet een maat zijn voor succes, dan is prestatiemanagement in de publieke sector een fenomenaal succes. Maar prestatiemanagement is in de praktijk niet zonder

Als aandacht en inzet een maat zijn voor succes, dan is prestatiemanagement in de publieke sector een fenomenaal succes. Maar prestatiemanagement is in de praktijk niet zonder problemen. Een fundamenteel aandachtspunt is het verhogen van de effectiviteit. Maar hoe kan dat?

Prestatiemeting en prestatiemanagement

Al ruim twee decennia vormt prestatiemanagement een van de meest wijdverspreide internationale trends in het openbaar bestuur. Prestatiemanagement is: “de activiteit van het proberen te managen (begroten, plannen, sturen, controleren, belonen, straffen etc.) met behulp van prestatiegegevens” (Pollitt, 2012). Aan prestatiemanagement gaat prestatiemeting vooraf: “het expliciet meten van prestaties, met behulp van indicatoren, doelen en/of normen.” Prestatiemanagement is onvermijdelijk voor elke publieke organisatie (Moynihan en Pandey, 2010). Met publieke financiën onder druk neemt de behoefte aan prestatiemanagement alleen maar toe, als middel om te demonstreren en veilig te stellen dat publieke projecten hun geld waard zijn. Tegelijkertijd is prestatiemanagement niet zonder problemen. Een paar voorbeelden:

- Er is verleiding om cijfers te manipuleren (Radin, 2006).

- Prestatie-informatie blijft (te) vaak grotendeels ongebruikt (Lægreid et al., 2006).

- Het is de vraag in hoeverre beslissingen van politici, publieke managers en burgers daadwerkelijk beïnvloed worden door prestatie-informatie (Van Dooren et al., 2010).

- De veelheid en fragmentatie van benchmarks in de publieke sector (Schurink en Wesseling, 2007).

De voorbeelden illustreren een behoefte en noodzaak om te werken aan beter prestatiemanagement. Met dit artikel willen we daaraan bijdragen. We beschrijven onze recente ervaringen met de totstandkoming van ‘Vensters voor Bedrijfsvoering’.

| Vensters voor Bedrijfsvoering Vensters voor Bedrijfsvoering, kortweg Vensters, is een instrument waarmee gemeenten, provincies en waterschappen zicht krijgen op het presteren en functioneren van hun bedrijfsvoering en dit kunnen spiegelen aan andere publieke organisaties. Vensters is een diagnose- en leerinstrument. Het helpt managers hun bedrijfsvoering inzichtelijk te maken en zo intern de dialoog te voeren over ambities, keuzen en verbeterpunten. Dit doet het instrument vanuit verschillende invalshoeken (of ‘vensters’), zowel met prestatie-indicatoren als met belevingsonderzoek. Sinds de introductie begin 2013 is het aantal deelnemers opgelopen tot over de honderd publieke organisaties. Dit aantal zal naar verwachting de komende jaren verder toenemen, gezien de actualiteit van het onderwerp bedrijfsvoering. |

Succesfactoren

Hoe te komen tot effectievere prestatiemeting en daarmee ook prestatiemanagement binnen de publieke sector? Dat is de centrale vraag van dit artikel. Op basis van recente publicaties en ervaringen met Vensters voor Bedrijfsvoering (in het vervolg: Vensters) komen wij, zonder uitputtend te willen zijn, tot de volgende succesfactoren:

- Co-creatie

- Eigen duiding

- Meervoudig kijken

- Focus op leren

- Hoge informatiekwaliteit

- De funfactor

Of deze succesfactoren van toepassing zijn, hangt natuurlijk samen met het doel van de prestatiemeting. Verschillende doelen bij prestatievergelijking (leren, transparantie, verantwoording, ondersteunen extern toezicht en het afrekenen op prestaties) vragen om een andere aanpak en invulling (De Bruijn, 2007).

Co-creatie

Co-creatie is een vorm van samenwerking waarbij mensen vanuit verschillende achtergronden bij elkaar komen rond een vraagstuk of thema en ieder een bijdrage levert (Berlo, 2012). Voorwaarde voor een goede prestatiemeting is dat diegenen die door het prestatiemanagement worden beïnvloed de meting accepteren en internaliseren (Van Dooren et al., 2010). Co-creatie helpt daarbij; co-eigenaarschap nog beter. Een systeem waarbij mensen prestatieindicatoren invullen voor anderen die voor hen zelf geen merkbaar nut hebben, is weinig robuust (Mayne, 2007).

Co-creatie vraagt veel inzet. Bijvoorbeeld al bij het gezamenlijk vaststellen wat de deelnemers precies willen meten en weten om te voorkomen dat appels met peren worden vergeleken (Schurink en Wesseling, 2007). Ook verderop in het proces is het belangrijk om betrokkenheid vast te houden en te vergroten. Dit door bijvoorbeeld regelmatig te evalueren, open te staan voor goed beargumenteerde wijzigingsverzoeken (hoe vervelend soms ook voor de vergelijkbaarheid), en vooral door gebruikers een finale stem te geven over de inhoud van de meting, de vragenlijst en rapportagevorm.

Co-creatie en interactie met de gebruiker komen al veel voor bij prestatievergelijkingen. Maar bij het huidige aanbod van prestatiemetingen en -vergelijkingen1 is in de meeste gevallen sprake van één afzender, één organisator. Het is de vraag of dit verstandig is. Het is goed om het benchmarkmodel te laten ontwikkelen door brancheorganisaties in samenwerking met onderzoeksbureaus (Poerstamper et al., 2007). Vanaf het begin gezamenlijk optrekken met relevante spelers geeft grote voordelen voor acceptatie en groeimogelijkheden en draagt ook bij aan het verminderen van het aantal elkaar overlappende benchmarkinitiatieven.

Tot slot nog het volgende. Verregaande samenwerking is cruciaal en tevens een enorme uitdaging. Maar hoe kom je tot besluiten bij onenigheid? Hoe borg je professionaliteit en continuïteit als betrokkenen allen een onderdeel van het werk doen? Het is onze ervaring dat co-creatie goed werkt zolang het belang van de gebruiker écht centraal staat. Zodra er ook andere belangen zijn werkt het niet.

| Co-creatie is bij Vensters uitgangspunt geweest. Het is een gezamenlijk initiatief van publieke organisaties: de Vereniging voor Gemeentesecretarissen, de Stichting ICTU, KING Gemeenten en de vakvereniging FAMO. Het initiatief wordt gesteund door het ministerie van Binnenlandse Zaken. Samenwerking is er op basis van gelijkwaardigheid. Deelnemers (gemeenten, waterschappen en provincies) brengen inhoudelijke kennis en ervaring in en zijn betrokken bij de doorontwikkeling van de methodiek. Deelnemers én initiatiefnemers beslissen samen in een stuurgroep met een deelnemer als voorzitter. |

Eigen duiding

Prestaties of uitkomsten in de vorm van cijfers zijn altijd een belangrijk onderdeel van een prestatievergelijking. Maar prestaties alleen hebben geen betekenis. Ze dienen ‘geduid’ te worden. De vraag is of het bij de duiding nodig is om normatief te zijn. Er zijn goede redenen om hier terughoudend mee te zijn. Normatieve uitspraken kunnen een open en lerende houding in de weg zitten en daarmee contraproductief werken. Bovendien is ‘het verhaal achter de cijfers’ belangrijk. Dat verhaal moet worden betrokken bij de analyse en vergelijking (L’Ortye en Van der Tempel, 2012). Een hoge score op een bepaald beleidsterrein kan immers het gevolg zijn van een bewuste politieke keuze die heel goed te rechtvaardigen is (Schurink en Wesseling, 2007). Ook kan de specifieke situatie van een organisatie of haar omgeving de uitkomsten verklaren. De deelnemer zelf kan de prestaties het beste duiden, maar daar moet dan wel de ruimte voor zijn.

| Bij Vensters staan de deelnemers nadrukkelijk zelf ‘aan de lat’ voor de interpretatie. De reden daarvoor is ook dat prestatievergelijking niet het einde is van een proces. Het is vooral het begin van een traject waarin zelf verbeteren en leren van anderen centraal staan. Een zelfgestelde diagnose is daarbij een veel beter uitgangspunt dan de conclusie van een derde. De organisator van de prestatievergelijking of liever nog collega-deelnemers vervullen bij de duiding vooral een ‘prikkelende’ en faciliterende rol door de positie ten opzichte van anderen inzichtelijk te maken. Dit gebeurt door de deelnemers met elkaar in verbinding te brengen rond thema’s of doelen en door te spiegelen, sparren en vragen te stellen en zo bij te dragen aan het geven van betekenis aan de uitkomsten. |

Meervoudig kijken

Meervoudig kijken helpt volgens Hoogwout (2004) om te voorkomen dat de interpretatie van resultaten wordt gemonopoliseerd. Meervoudig kijken door gebruik te maken van verschillende invalshoeken vergroot ook de bruikbaarheid van de prestatiemeting. De Bruijn (2007) raadt aan een brede set van indicatoren en/of verschillende typen informatie te gebruiken, waaronder ook kwalitatieve informatie. Het is daarnaast goed om ook de kennis van de specifieke situatie te benutten (Radin, 2006). Het gebruiken van verschillende invalshoeken kan iets zijn dat je rondom een methodiek organiseert, bijvoorbeeld door verschillende databronnen te gebruiken. Het is ook mogelijk het in een methodiek in te bouwen. Door bijvoorbeeld naast feitenonderzoek (indicatoren) ook belevingsonderzoek in het instrument op te nemen.

Het gebruik van meer invalshoeken verhoogt de gebruikswaarde. Organisaties zijn immers niet eendimensionaal. Managers en medewerkers hebben te maken met en kijken zelf ook vanuit verschillende perspectieven naar ‘de werkelijkheid’. Naast het vergroten van de bruikbaarheid is er een tweede argument voor het hanteren van meer invalshoeken: het vergroten van het vertrouwen in de uitkomsten. Zonder vertrouwen in de uitkomsten is de kans klein dat er iets mee wordt gedaan. Hoogwout (2004) stelt dat het vertrouwen groeit als uitkomsten in lijn zijn met indrukken uit andere informatiebronnen. Het gebruik van meer informatiebronnen doet het effect van de benchmark toenemen, juist doordat deze niet als enige de waarheid in pacht heeft.

Maar hoeveel verschillende invalshoeken moeten dan in het instrument worden opgenomen? Ofwel hoe compleet en gedifferentieerd moet het instrument zijn? Gebruikers willen een zo eenvoudig mogelijk instrument, om zo de (cumulatieve) invultijd beperkt te houden. Anderzijds moet het onderzoek wel voldoende informatie opleveren. Het vinden van de juiste balans is de kunst.

| Bij Vensters krijgen we bijvoorbeeld regelmatig vragen of onderwerp ‘X’ er ook in kan. Beknoptheid en compleetheid zijn tegenstrijdige eigenschappen, een tweestrijd die waarschijnlijk inherent is aan de methodiek. Het is onze ervaring dat het loont om kritisch te zijn op uitbreidingswensen, geredeneerd vanuit het doel van het instrument. Vragen die daarbij kunnen helpen zijn vragen als: ‘Is de uitbreiding een gedeelde wens?’, ‘Gaat het deelnemers noodzakelijke extra inzichten verschaffen, of is het alleen interessant?’ en ‘Hoe verhoudt de verwachte opbrengst zich tot de extra inspanning?’. Ook hier geldt ‘de gebruiker is leading’. |

Focus op leren

Organisatieleren staat al wel zeker sinds de jaren tachtig van de vorige eeuw prominent op de onderzoeksagenda (Pawlowsky, 2003). Het is een belangrijk thema bij prestatiemanagement. Er valt veel meer over te zeggen dan we in één paragraaf kunnen doen, maar in de context van dit artikel willen we er twee dingen over zeggen.

Prestatievergelijking kan verschillende doelen hebben: leren, transparantie, verantwoording afleggen, vergelijkend toezicht en als afrekeninstrument. In algemene zin is het devies leren centraal te stellen en niet informeren of verantwoorden. Zo geeft de Raad voor het Openbaar B estuur (ROB) al in 2002 aan: “Voorkomen moet dus worden dat benchmarks worden ingezet als verticaal verantwoordingsinstrument tussen gemeenten en provincies enerzijds en het rijk anderzijds.” Schurink en Wesseling (2007) wijzen op het belang vooraf met elkaar vast te stellen dat het bij benchmarking uiteindelijk gaat om het ontdekken en toepassen van best practices, en niet om het doen ‘rollen van koppen’. Verantwoording op basis van prestatie-indicatoren vereist een stabiliteit en robuustheid die vaak niet kan worden waargemaakt (Moynihan, 2008). De Bruijn (2007) signaleert een ‘Wet van afnemende effectiviteit’: hoe ambitieuzer de functie van prestatie-informatie, hoe groter het risico op perverse effecten en hoe minder effectief de prestatiemeting is.

Het tweede punt gaat over de manier waarop mensen leren. Over hoe organisatieleren nu precies in zijn werk gaat verschillen de meningen. Aan de ene kant zijn er onderzoekers zoals Berends et al. (2003) die stellen dat organisatieleren in feite het leren is van belangrijke personen of een dominante coalitie van personen. Daartegenover staan onderzoekers als Brown en Duguid (1991) die leren op de werkplek beschouwen als een proces van communityvorming. Bij Vensters omarmen we beide stromingen. Actie gericht op personen (bijvoorbeeld controllers of directeuren) wordt gecombineerd met leerkringen.

| Leerkringen vormen een belangrijk onderdeel van Vensters. Daar kom je met collega’s uit andere organisaties (gemeentesecretarissen, controllers, sectorhoofden e.d.) bij elkaar. De deelnemers zijn zelf eigenaar van de leerkring, zij bepalen de onderwerpen, focus, diepgang, en dergelijke. Resultaten van Vensters fungeren als trechter naar mogelijk interessante onderwerpen (waar zitten opvallende resultaten?) en als gespreksstarter over de onderwerpen (kun je iets meer vertellen over jullie aanpak?). |

Hoge informatiekwaliteit

Hoge kwaliteit van informatie vergroot de bruikbaarheid van de uitkomsten en draagt bij aan het draagvlak. (Poerstamper et. al., 2007). Dit lijkt een open deur maar de aandacht die organisaties hebben voor deze kwaliteitsverbetering is niet altijd evident (Van Dooren et al. 2010). Belangrijke aspecten van kwaliteit die een boost kunnen geven aan het gebruik van prestatie-informatie zijn de validiteit, accuraatheid, tijdigheid en analyse (Hatry, 2008).

De ROB (2002) wordt ten aanzien van de kwaliteit van de prestatie-indicatoren nog concreter. Wat de ROB betreft gelden criteria als eenduidig en duidelijk geformuleerd, meetbaar en in de tijd vergelijkbaar, relevant en voor langere tijd leverbaar, periodiek leverbaar tegen aanvaardbare kosten, betrekking hebbend op homogene en kwantificeerbare grootheden, mogelijkheid om tussentijds te evalueren en bij te stellen en opgesteld te zijn in samenspraak met de organisaties.

Voor de informatiekwaliteit geldt dat deze zo hoog mogelijk moet zijn. Naast dit ‘absolute’ standpunt valt er veel te zeggen voor een ‘relatief’ standpunt. Het doel van de vergelijking en de mogelijke gevolgen voor de organisatie zijn belangrijke uitgangspunten voor het vaststellen van de benodigde informatiekwaliteit. Over het algemeen geldt dat er hogere eisen aan betrouwbaarheid en validiteit worden gesteld, naarmate de gevolgen voor de organisaties in kwestie groter en directer zijn (BZK, 2004). Als leren het doel is, moet het instrument vooral signaleren en kun je met een lagere nauwkeurigheid genoegen nemen dan bij afrekenen als doel.

| Spiegelen en leren is het primaire doel van Vensters. De indicatoren en definities zijn zodanig gekozen dat zij dit doel dienen (signalerende functie). Alle indicatoren zijn voorzien van gestandaardiseerde definities, waarbij een optimale balans wordt gezocht tussen precisie, onderlinge vergelijkbaarheid en werkbaarheid voor de deelnemers. De definities zijn tot stand gekomen in overleg met deelnemers om te waarborgen dat zij aansluiten bij in de praktijk gebruikte definities en opleverbaar zijn uit de administraties van de deelnemers. Daar waar mogelijk betrekken we informatie uit al bestaande bronnen. De validiteit wordt geborgd door controles op de ingevoerde gegevens. Opvallende afwijkingen worden opgespoord en gecontroleerd op juistheid. |

De funfactor

Deze factor heeft betrekking op de mate waarin een prestatievergelijking voorziet in de behoefte met leuke en interessante dingen bezig te zijn. Geeft het me energie om hiermee bezig te zijn? Leer ik er van? Kan ik mijn kennis en kunde erin kwijt? Anders dan bij de andere beschreven factoren gaat het hier meer om subjectieve menselijke behoeften. Die zijn relevant want het zijn mensen die geprikkeld worden en in actie komen, niet systemen of organisaties. Deze factor voegen we toe op basis van onze ervaring, want in de literatuur over prestatiemanagement of benchmarking is er opvallend genoeg weinig aandacht voor. Illustratief in dit verband is de volgende zin: “Ten slotte zou de geïnterpreteerde prestatie-informatie moeten worden gerapporteerd in een voor de doelgroep geschikte vorm.” (Van Dooren et al., 2010). Met die constatering zijn we het volmondig eens, maar we denken tegelijkertijd dat voor een succesvolle benchmark de lat op dit gebied veel hoger moet liggen.

Succesvolle benchmarkinitiatieven slagen er volgens ons in mensen te prikkelen en enthousiasmeren. Ze bieden persoonlijke meerwaarde voor de deelnemers, door ontmoeting en de inhoud. Ze sluiten met hun indicatoren en in leersettingen aan op actuele thema’s. Ze ontsluiten op zichzelf droge materie op een aantrekkelijke en zeer toegankelijke manier, zodat het uitnodigt ermee te gaan spelen (serious gaming). Duidelijke en snelle presentatie van prestatie-informatie kan bovendien helpen de informatieoverload van besluitvormers te helpen verminderen (Hatry, 2008). Moderne ICT-middelen als apps, social media en geavanceerde onderzoeksplatforms dragen bij aan de funfactor. Het gaat daarbij niet om ‘spiegeltjes en kraaltjes’, maar om de manier waarop vorm en functie elkaar kunnen versterken. Dat perspectief kan veel initiatieven van prestatiemeting en -vergelijking aantrekkelijker én effectiever maken.

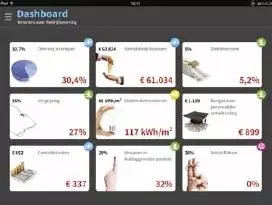

| Bij Vensters worden de resultaten onder andere in een app gepresenteerd. De app ontsluit de informatie op verschillende manieren. De gebruiker ziet allereerst een dashboard op hoofdlijnen met de eigen waarde en een geselecteerde benchmark (zie afbeelding). Bij doorklikken zijn benchmarkgrafieken beschikbaar met zelf geselecteerde vergelijkingspartners. De volledige definities van de indicatoren zijn direct naast de grafieken te lezen. |

Conclusie

In dit artikel hebben we, op basis van literatuur en de ervaringen met Vensters, vijf manieren beschreven om bestaande en nieuwe initiatieven van prestatievergelijking en prestatiemanagement te verbeteren: co-creatie, eigen duiding, verschillende invalshoeken, focus op leren, werken aan een hoge informatiekwaliteit en de funfactor. In totaal zes manieren om toe te werken naar een betere omgang met prestatievergelijking en een betere benutting van de uitkomsten. Aan publieke organisaties, adviesbureaus en koepelorganisaties de uitdaging om deze handschoen op te nemen.

Drs. Daniël van Geest is projectleider bij ICTU. Drs. Ing. Cees van der Zwan is projectleider bij ICTU en eigenaar van Newgo. Ir. Jurgen Visser is adviseur bij ICTU.

Noot

1 KING geeft op haar site www.waarstaatjegemeente.nl een overzicht van gecertificeerde benchmarks voor de gemeentelijke sector.

Literatuur

- Berends, H., Boersma, K. & Weggeman, K. (2003), ‘The structuration of organizational learning’, in Human Relations. 56(9), pp. 1035-1056.

- Berlo, D. van (2012), Wij, de overheid. Cocreatie in een netwerksamenleving, Programma Ambtenaar 2.0.

- Brown, J.S. & Duguid, P. (1991), ‘Organizational learning and communities of practice: Towards a unified view of working, learning and innovation’, in: Organizational Science. 2(1), pp. 40-57.

- Bruijn, H.D. (2007), Managing Performance in the Public Sector, 2nd ed. London: Routledge

- Curristine, T. (2005), ‘Performance Information in the Budget Process: Results of the OECD 2005 Questionnaire’, in: OECD Journal on Budgeting, Vol. 5, No. 2, OECD, Paris, pp. 87-132.

- Dooren, W. van (2011), ‘Better Performance Management. Some single and double loop strategies’, in: Public Performance & Management Review, Vol. 34, No. 3, March 2011, pp. 421-434.

- Dooren, W. van, Bouckaert, G. & Halligan, J. (2010), Performance management in the public sector, London: Routledge.

- Hatry, H. P. (2008), ‘The many faces of use’, in: Dooren W. van & Walle S. van de (Eds.), Performance information in the public sector: how it is used, Basingstoke: Palgrave Macmillan, pp. 125-140.

- Hoogwout, M. (2004), ‘Het ontwerpen van overheidsbenchmarks – Een krachtig management- en verantwoordingsinstrument’, in: TPC, jaargang 2, juni 2004, pp. 32-42.

- Lægreid, P., Roness P. &. Rubecksen K (2006), ‘Performance management in practice: The Norwegian way’, in: Financial Accountability and Management, 22(3): pp. 5-70.

- L’Ortye, F. en Tempel, A. van der (2012), ‘Benchmark, instrument voor efficiëntie bij gemeenten?’, in: TPC, jaargang 10, oktober 2012.

- Mayne, J. (2007), ‘Challenges and lessons in implementing resultsbased management’, in: Evaluation, 13(1), pp. 87-109.

- Ministerie van Binnenlandse Zaken (2004), Handboek Prestatievergelijking binnen de openbare sector.

- Moynihan, D. (2008), The dynamics of performance management, Washington DC: Georgetown University Press.

- Moynihan, D.P. & Pandey, S.K. (2010), The Big question for Performance Management: Why Do Managers Use Performance Information?, JPART 20: 849-866.

- Pawlowsky, P. (2003), ‘The treatment of organizational learning in management science’, in: Dierkes M., Antal, A.B., Child J. & I. Nonaka (Eds.), Handbook of organizational learning & knowledge, Oxford: Oxford University Press, pp. 61-88.

- Poerstamper, R.J.C. et al. (2007), Benchmarking in de zorg: Op weg naar een excellente organisatie, Maarssen: Elsevier Gezondheidszorg.

- Pollitt, C. (2012), The logic and limits of performance management, draft paper tot be presented at EGPA, Bergen.

- Radin, B. (2006), Challenging the performance movement: accountability, complexity, and democratic values, Washington DC: Georgetown University Press.

- Raad voor het Openbaar Bestuur (2002), Presteren door leren, benchmarking in het binnenlands bestuur, Den Haag: oktober 2002.

- Schurink, M. & Wesseling, H. (2007), ‘Benchmarking en de ambitie van zelfregulering’, in: TPC, jaargang 5, nr. 4, augustus 2007, pp. 2-7.